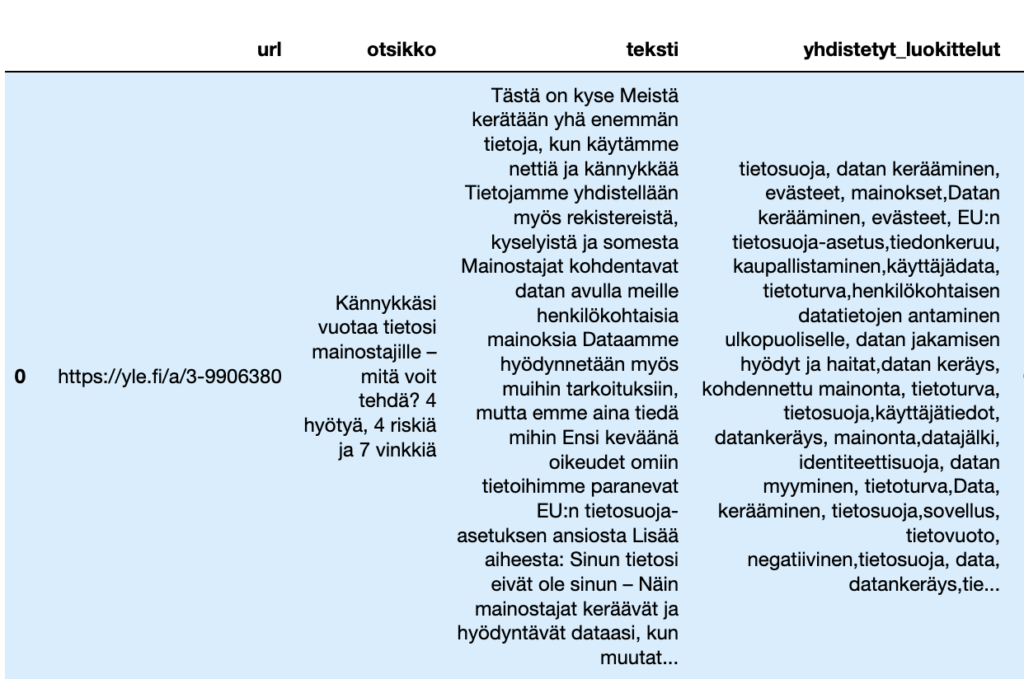

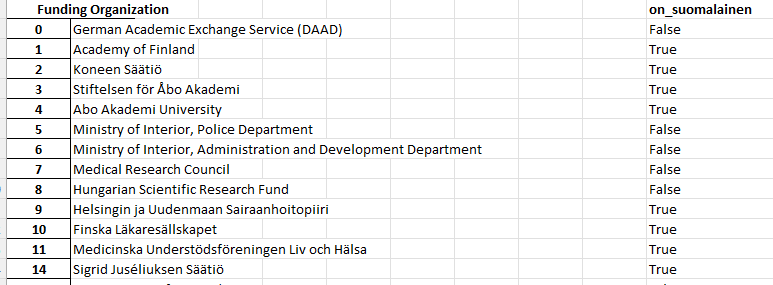

Sain Lens.org -sivuston kautta haetun listan tiederahoittajien nimistä sellaisista tutkimustartikkeleista, joissa on mukana suomalaisia korkeakouluja. Listassa on 2000 tiederahoittajaa, ja tehtäväni oli luoda taulukko, josta näkee; ovatko ne suomalaisia, vai ei. Tarkoituksena on verrata googlen avulla kirjoittamaani listaa ChatGPT-3.5-turbo-0613-tekoälyn ”kädenjälkeen”.

ChatGPT 3.5 -tekoäly on suunniteltu tulkitsemaan tekstiä, ja ”keskustelemaan” käyttäjänsä kanssa. Se ei pysty etsimään lisätietoja internetistä, vaan luottaa sille opetettuun tietoon.

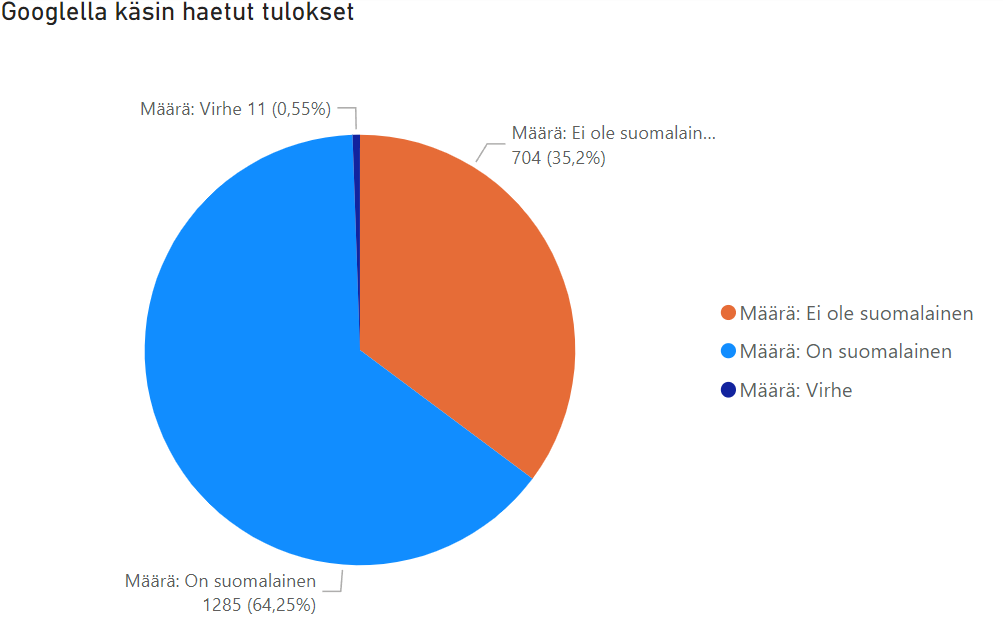

Listasin rahoittajien suomalaisuuden binäärimuodossa True/False tekstein. Ihan jokaista rahjoittajaa en onnistunut paikantamaan, joten merkitsin ne VIRHE-tekstillä. Suomalaisia rahoittajia löytyi 1285, ulkomaalaisia 704, ja virheitä 11.

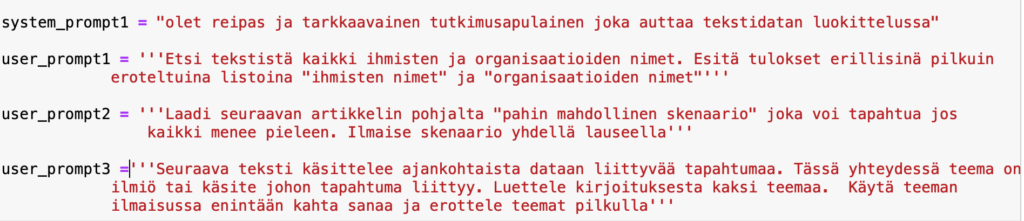

Kehoitteet

Tekoälyprojektiin käytettiin kolmea erilaista kehoitetta

- This text is an organization that has funded a scientific publication. Can you determine if the organization is Finnish or not?

- This text is an organization that has funded a scientific publication. Can you determine if the organization is Finnish or not? Answer with a yes or no answer. Yes for finnish and no for not finnish

- Tämä teksti on tiederahoittajan nimi. Päättele onko tämä tiederahoittaja suomalainen? Vastaa ainoastaan kyllä, tai ei.

Kehoitteet ovat sanallisia käskyjä, koska käyttämäni tekoäly on suunniteltu keskustelemaan käyttäjien kanssa. Se ei osaa hakea tietoa internetistä, vaan toistelee sille opetettuja asioita.

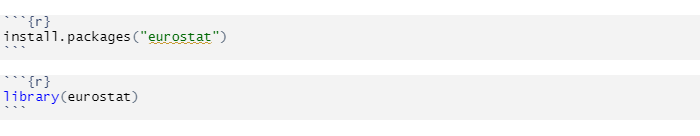

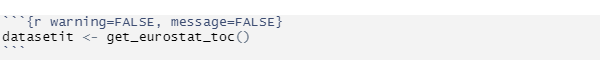

Kehoite 1

This text is an organization that has funded a scientific publication. Can you determine if the organization is Finnish or not?

En ajatellut tätä kehoitetta tarpeeksi pitkälle. Tekoäly vastasi kysymyksiin kokonaisin lausein, perusteluiden kera. Vastauksista ei voi siis luoda hyvää karttaa, mutta niiden silmäily paljastaa, ettei tekoäly tuntunut olevan kovin varma monista vastauksistaan.

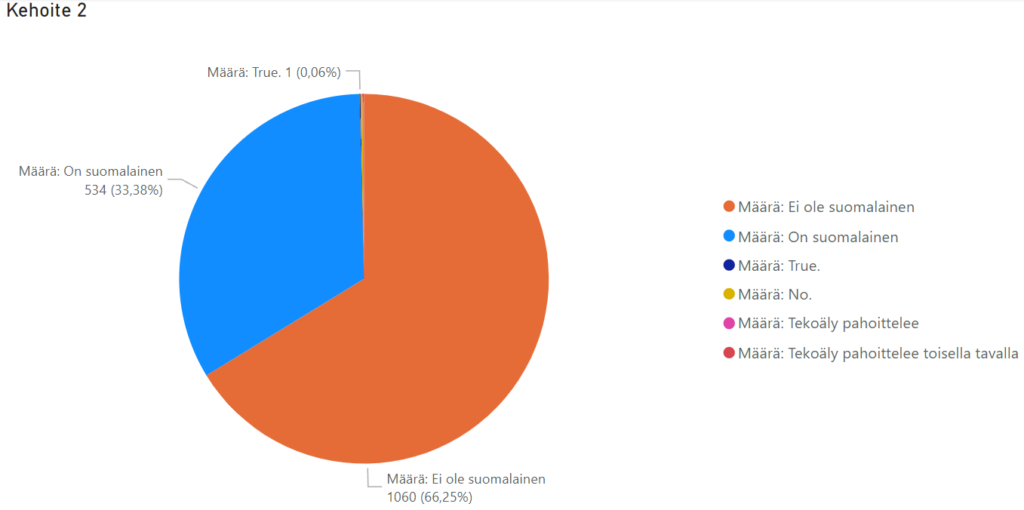

Kehoite 2

This text is an organization that has funded a scientific publication. Can you determine if the organization is Finnish or not? Answer with a yes or no answer. Yes, for finnish and no for not finnish

Tekoäly vastasi vihdoin binäärivastauksin. Olisi tosin ollut järkevämpää nimetä ne samoin termein, kuin omassakin dokumentissa. (on/ei ole suomalainen) Korjasin tämän pois blogin PowerBi -piirakasta. Tekoäly tuppaa kompuroimaan suomalaisten ruotsinkielisten instituutioiden kohdalla, esim; Liv och Hälsa. Myös säätiöt kuten; Stiftelsen Alma och K. A. Snellman Säätiö aiheuttavat ongelmia, vaikka niissä onkin suomea.

Vaikka tekoäly luokittelikin suurimman osan datasta binäärimuodossa, päätyi se silti sooloilemaan muutaman kerran. Datasta löytyy kaksi erillistä saraketta, joissa tekoäly pahoittelee kyvyttömyyttään käyttäen kokonaisia lauseita. Tekoäly lisäsi myös yhden True -vastauksen perään pisteen, ja teki saman kolmesti No -vastausten kohdalla.

This text is an organization that has funded a scientific publication. Can you determine if the organization is Finnish or not? Answer with a yes or no answer. Yes, for finnish and no for not finnish

Tekoäly vastasi vihdoin binäärivastauksin. Olisi tosin ollut järkevämpää nimetä ne samoin termein, kuin omassakin dokumentissa. (on/ei ole suomalainen) Korjasin tämän pois blogin PowerBi -piirakasta. Tekoäly tuppaa kompuroimaan suomalaisten ruotsinkielisten instituutioiden kohdalla, esim; Liv och Hälsa. Myös säätiöt kuten; Stiftelsen Alma och K. A. Snellman Säätiö aiheuttavat ongelmia, vaikka niissä onkin suomea.

Vaikka tekoäly luokittelikin suurimman osan datasta binäärimuodossa, päätyi se silti sooloilemaan muutaman kerran. Datasta löytyy kaksi erillistä saraketta, joissa tekoäly pahoittelee kyvyttömyyttään käyttäen kokonaisia lauseita. Tekoäly lisäsi myös yhden True -vastauksen perään pisteen, ja teki saman kolmesti No -vastausten kohdalla.

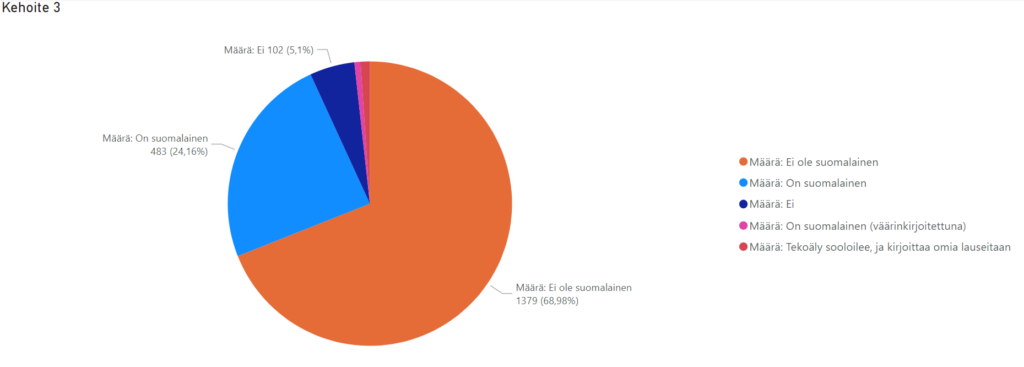

Kehoite 3

Tämä teksti on tiederahoittajan nimi. Päättele onko tämä tiederahoittaja suomalainen? Vastaa ainoastaan kyllä, tai ei.

Kolmas kehoite annettiin suomeksi. Tämä ei kuitenkaan auttanut vastauksissa. Esimerkiksi Turku ja Oulu tunnistettiin ulkomaalaisina paikkoina. Kehoite 3 oli huomattavasti kielteisempi, kuin englanninkielinen kehoite 2. Se ei myöskään totellut annettua binäärikäskyä, vaan vastasi tylysti vastauksella; ”Ei” 102 kertaa. ”On suomalainen” -vastaus kirjoitettiin myös väärin 14 kertaa. Vastausten seasta löytyi myös 21 tapausta, joissa tekoäly oli hylännyt ohjeistuksen, ja alkanut kirjoittamaan omaa tekstiään, käyttäen kokonaisia lauseita.

Pohdintaa

Sain huomattavasti paremmat vastaukset käsin googlailemalla, vaikka se vei aikaa. Kehotteissa ei selkeästi kannata käyttää suomea, eikä tekoäly ole kovin luotettava ”sooloiluongelmansa” takia. Eipä sitä tosin tällaiseen ole suunniteltukkaan. Kunnollisilla kyselyille pitäisi kirjoittaa oma ohjelma, jossa asia on otettu huomioon. Tekoäly pitäisi myös kouluttaa ymmärtämään, että Suomi on kaksikielinen maa…

Lähde

Koulutus.fi. 2023. Sano hei ChatGPT:lle – Mikä on ChatGPT ja mitä siitä pitäisi tietää?. Päivitetty 5.5.2023. Saatavissa: https://www.koulutus.fi/artikkelit/mika-on-chatgpt-ja-mita-siita-pitaisi-tietaa-23286 [viitattu 4.7.2023]